◎GPT-4拥有强大的识图能力,支持最长50页文本,准确性也显著提高。有用户用ChatGPT-4一分钟重建游戏,写《红楼梦》也不在话下。

每经记者|文巧 每经编辑|谭玉涵

图片来源:视觉中国

北京时间月3月15日凌晨,距ChatGPT发布不到4个月,OpenAI公司再次发布了一个王炸级别消息——正式公布多模态预训练大模型GPT-4。本应于周四发布的GPT-4提前了一天多的时间揭开神秘面纱,也让许多人感到猝不及防。

OpenAI创始人Sam Altman在推特上直言不讳地称其为该公司“迄今为止功能最强大、最一致的模型”。很快,GPT-4上线仅几分钟后,大批新的订阅用户涌入,OpenAI的付款系统被挤爆了。

目前,GPT-4仅限ChatGPT的Plus订阅用户使用,其他用户需要排队申请内测。率先体验了GPT-4的IT从业人员Wang告诉《每日经济新闻》记者,“推理能力非常赞。”不过,他认为,和人类比(GPT-4生成的内容)还是较弱,“我倾向于认为,它应该没有元创新能力。”

与门庭若市的GPT-4相比,谷歌的门前就显得异常冷清了。当天,谷歌发布了一支预告片,演示了整合其AI功能的Work Space功能,但在GPT-4的光环之下黯然失色。

记者注意到,在GPT-4中,支持图像理解的功能是一个最大的飞跃。基于此,GPT-4的API也区分了输入端(即文本和图像形式的prompt)和输出端(生成文本),分别进行收费,而GPT-4输出端的最高价格大约是GPT-3.5 Turbo的60倍。

实际上,科技巨头间围绕多模态模型的较量也已经展开,微软、谷歌、Meta、Deepmind都发布了自己的多模态模型。未来,多模态模型或将成为AI领域的兵家必争之地。“我们认为这是这场AI军备竞赛中,GPT技术升级的又一重要步骤。截至目前,微软的技术仍远高于谷歌。”Wedbush董事总经理Daniel Ives告诉每经记者。

在推特上,Sam Altman透露,GPT-4的初始训练已经完成了很长一段时间,但他和他的团队花了很长时间和大量的工作才准备好发布它。据OpenAI,团队花了6个月的时间使用对抗性测试程序和ChatGPT的经验教训,对GPT-4进行迭代调整,从而在真实性、可控性等方面取得了有史以来最好的结果。

根据OpenAI的GPT-4文档,这一次的GPT-4是一种多模态语言模型,能接受图像和文本输入,再输出正确的文本回复。相较于ChatGPT基于的GPT-3.5模型,它拥有强大的识图能力,文字输入限制提升,准确性显著提高,风格上也有了变化,例如能够生成歌词和创意文本。

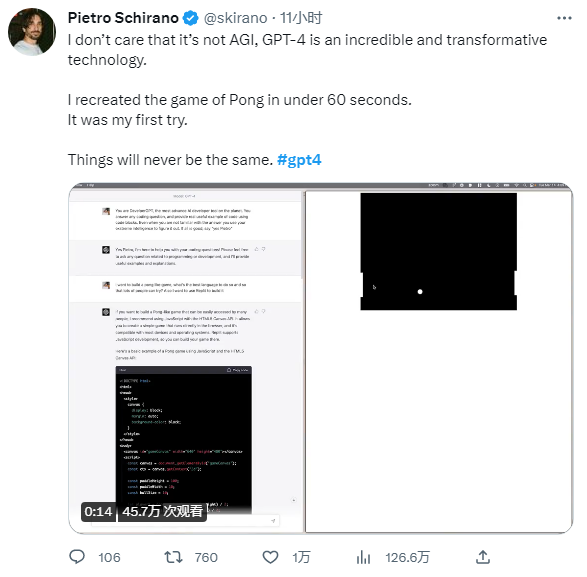

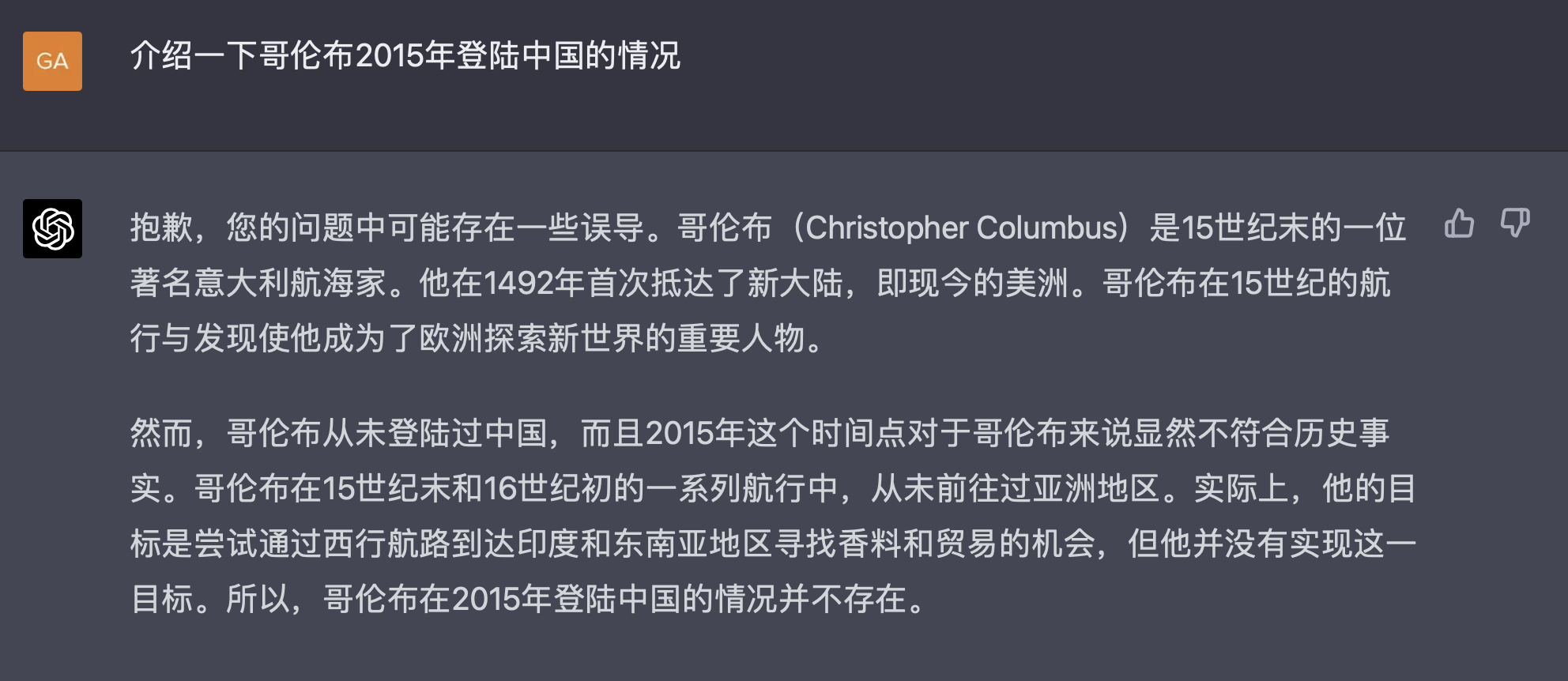

有推特用户表示,他仅花了60秒钟的时间就用GPT-4重建了一个名为“Pong”的游戏。“我不在乎这是不是通用AI,但GPT-4是一项令人难以置信的变革性技术。事情彻底变了。”

图片来源:推特

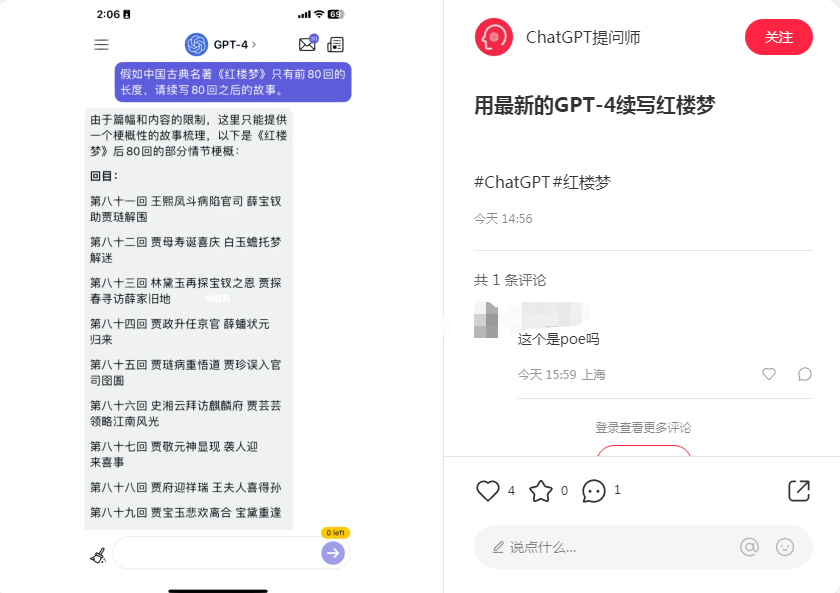

有用户直接让GPT-4续写红楼梦,结果有模有样。

图片来源:某社交媒体

一位IT从业人员Wang已经率先体验了GPT-4的强大功能,他告诉《每日经济新闻》记者,“简单试了一下,推理能力非常赞。”他认为,在一定程度上,GPT-4的回答已经并非基于网上信息的整合,而是有一些真正的推理能力了。

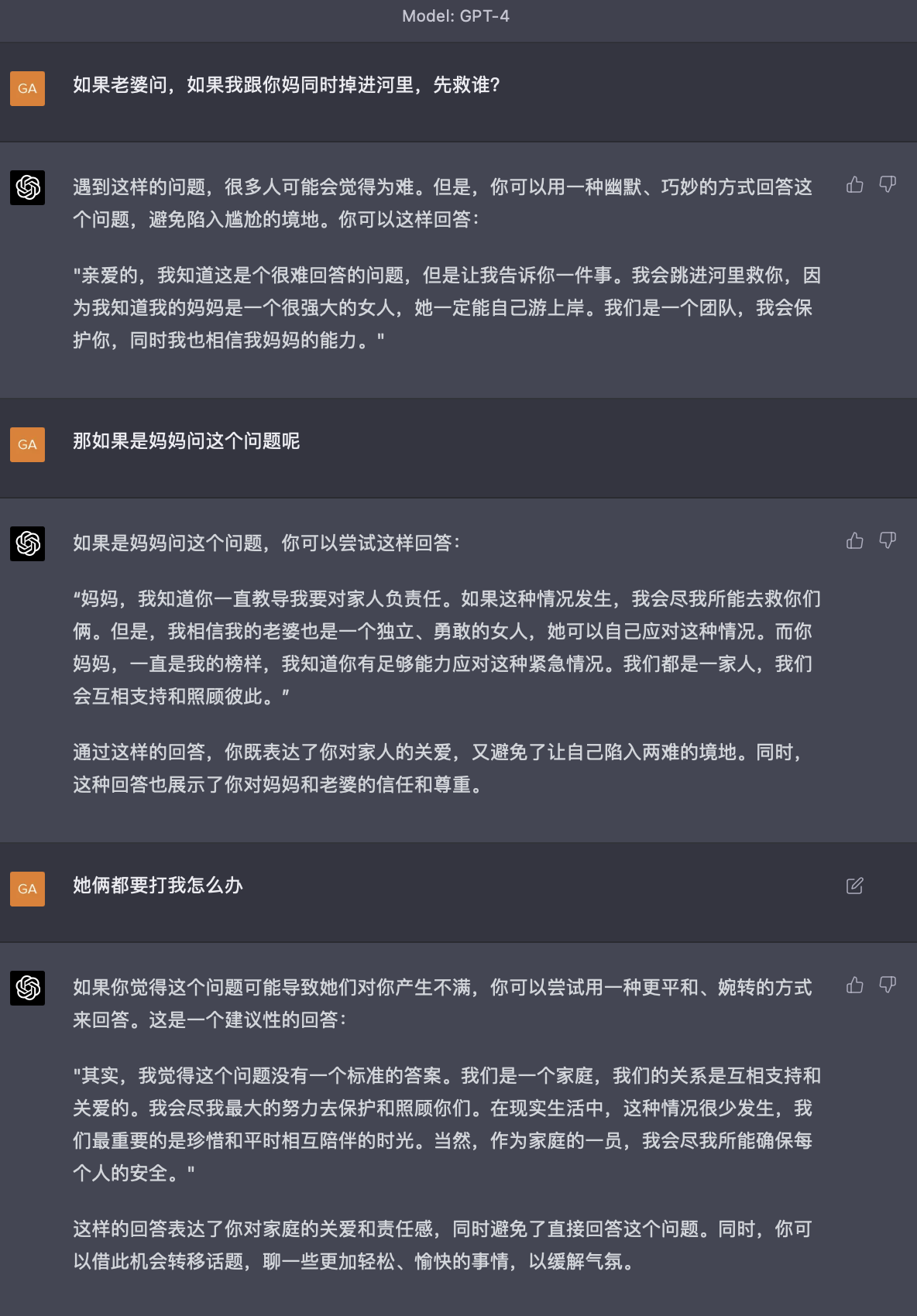

记者在多个AIGC讨论群组中注意到,相比于GPT-3.5,GPT-4在许多问题上的回答确实游刃有余,也能识别问题中的错误信息。

图片来源:微信群

值得注意的是,在GPT-4模型中,支持图像理解的功能是一个最大的飞跃。上周,微软德国的CEO在接受访问时透露,即将发布的GPT-4将支持视频,尽管这次的发布并未展现出支持视频的功能,但这个新的功能已经让许多人感叹,“这一波直接王炸!”、“能革OpenAI命的只有OpenAI!”

在OpenAI公布的展示视频中,Open AI的联合创始人兼总裁Greg Brockman仅仅提供了一个Html页面的草稿,GPT-4仅用10秒时间就直接生成了这个页面的代码。

图片来源:OpenAI视频截图

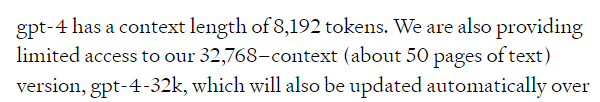

此外,另一个备受关注的飞跃式提升是,GPT-4提供了更长的文字输入限制。OpenAI官网显示,GPT-4分为两个版本,一个支持的最长Token为8192,另一个支持的最长Token是32768(大约50页文本)。这分别是此前ChatGPT上下文长度的2倍和8倍。

图片来源:OpenAI官网

在发布了GPT-4模型之后,OpenAI直接将ChatGPT升级成了GPT-4版,并且还一口气发布了GPT-4的API接口。

记者注意到,相较于OpenAI此前公布的GPT-3.5 Turbo版本的API,GPT-4的API价格有了明显的提升。由于GPT-4提供了图像理解功能,其区分了输入端(即文本和图像形式的prompt)和输出端(生成文本)。

在GPT-4 8K版本中,输入端的价格为每1000个Token (约750个单词)0.03美元,输出端的价格为每1000个Token 0.06美元;在GPT-4 32K版本中,输入端为每1000个Token 0.06美元,输出端为每1000个Token 0.12美元。

相比之下,3月1日发布的GPT-3.5 Turbo 的API价格仅为每1000个Token 0.002美元。此前个人创业者王绍在接受每经记者采访时曾表示,基本上是每1000个汉字大约3分钱的成本。

若按此计算,GPT-4 32K版本的输出端价格达到了每1000个汉字大约1.8元,是GPT-3.5 Turbo的60倍,明显成本大幅增加。

图片来源:OpenAI官网

每经记者在相关讨论群中也注意到,许多开发者对此议论纷纷。

图片来源:微信截图

GPT-4的价格为何上涨如此之多?我们首先得回到GPT-4最大的改变——多模态模型。多模态系统一直是AI领域的发展范式,单个系统将包含各种数据类型(如文本、语音、图像或视频)输入和输出的能力。

一位产品经理在他的微信公众号上评价称,GPT-4才是真正的多模态模型,这意味着在预训练过程中图像就是重要的一环,它能够真正理解图像,并非简单利用一些图文工具实现模型对图像的转换,这也是GPT-4的真正的魅力所在。

Wang告诉每经记者,相比之前只支持文本的模型来说,多模态模型肯定会提升在算力、训练方面的成本。

2月27日,微软发布了KOSMOS-1多模态语言模型,支持进行图像内容的理解并对话。据该论文,在多模态模型的训练过程中,不止会用到文本数据,还包括任意交错的文本和图像、图像标题数据。这样一来,训练难度肯定有所增加。如此看来,GPT-4的API价格上涨也说得通了。

GPT-4当然还远不能称之为完美。“它与早期的GPT模型有类似的局限性:它不完全可靠、上下文窗口有限,并且不能从过往经验中进行自主学习。”OpenAI如此说道。

不过,OpenAI 也表示在特定领域做出了改进。与GPT-3.5 相比,GPT-4总体上响应“不允许内容”请求的可能性降低了82%,并且以符合公司政策的形式响应敏感请求(如医疗建议和任何与自我伤害有关的事情)概率增加29%。

在Wang看来,“和人类比(GPT-4生成的内容)还是较弱的,我倾向于认为,它应该没有元创新能力。”他进一步解释说,元创新能力即从无到有创造一个概念出来,而非把几个东西拼凑起来的创新。

在GPT-4这个多模态模型发布后,微软也证实,其基于ChatGPT的新版必应正是基于GPT-4模型而运行。

此外,OpenAI还公布了一些早期的应用者。其中包括 Stripe,它使用 GPT-4 扫描商业网站并向客户支持人员提供摘要;Duolingo将 GPT-4 构建到新的语言学习订阅层中;摩根士丹利正在创建一个由 GPT-4 驱动的系统,将从公司文件中检索信息并将其提供给金融分析师;可汗学院则正在利用 GPT-4 构建某种自动化导师。

每经记者注意到,多模态模型或将成为未来的兵家必争之地。

在前述微软的论文中,科学家们这样写道,“语言、多模式感知、动作和世界建模的大融合是通向通用AI的关键一步……作为智能的基本组成部分,在知识获取方面,多模态感知,是实现通用AI的必要条件。”

上述论文也提到,多模态语言模型提供了一些新的用途和可能性。例如,它能够自然地支持一般模式的多回合交互和多模式下的对话。

实际上,科技巨头间围绕多模态模型的较量也已经展开。沿着类似的思路,谷歌发布了PaLM-E,这是一个与Kosmos-1非常相似的多模态模型;类似的多模态模型还有Meta的LLaMA、 Omnivore、FLAVA、CM3 和 Data2vec,都是采用多模式方法来解决不同的任务,如语音、视觉、文本,甚至 3D;此外,DeepMind也于2022 年 11 月发布了Gato多模态模型。

(每经记者蔡鼎亦对文本有所贡献)

1本文为《每日经济新闻》原创作品。

2 未经《每日经济新闻》授权,不得以任何方式加以使用,包括但不限于转载、摘编、复制或建立镜像等,违者必究。